Google I/O 開催中なので Google 関係のニュースが色々飛び回っているのですが、こいつは見過ごすわけにはいかない「TensorFlowを使ってニューラルシンセサイザーを作ってます!」という奴。そうかー、ついにそこに来たかー。

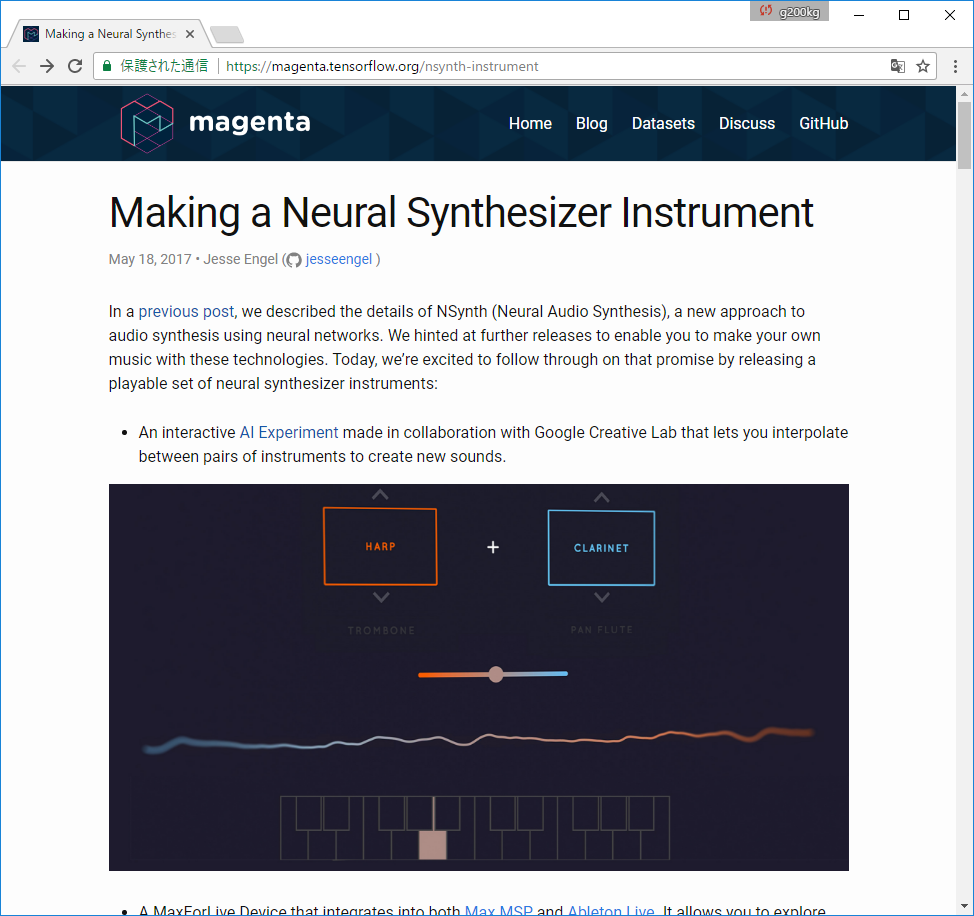

これは機械学習をアートに応用しようという「Magenta」プロジェクトの一部のようで、去年までは自動作曲なんかのデモをやっていたのですが、この4月にシンセサイザーへの応用の話を出していて5月18日に実際に演奏可能なデモ (NSynth) を発表したという事のようです。まだ色々と可能性を試しつつ基本的な実験を進めているという段階だと思いますが、取りあえずどういうものかブラウザ上で音がだせるデモページと MAX および Live で使用できる MAXforLiveデバイスが公開されています。

これは2つの音を入力して音の特徴を表すパラメータを抽出し、補間して再構成する事でいわゆる音色のモーフィングを行うというものです。猫の鳴き声とフルートの音を入力すると猫っぽいフルートになる、と。これはもちろん単純にミックスするというような話ではなく、猫の鳴き声とフルートの音の特徴を併せ持った新しい音色を生成するという意味です。

構造的にはパラメータを抽出する部分を Temporal Encoder、パラメータから波形の再構築を行う部分を WaveNet と呼んでいるようです。

取りあえずニューラルシンセサイザーのページにアクセスして、図の上にある「AI Experiment」のリンクから飛ぶとデモページに行けます。赤い四角と青い四角でそれぞれ音色を選んでその中間をモーフィングできるというデモですね。また実際に Ableton Liveで使える MAXforLiveデバイスは図の下にある DOWNLOAD リンクからダウンロードできます。

https://magenta.tensorflow.org/nsynth-instrument

さて、ニューラルシンセサイザーなんて語感だけで強そうですが、実は言葉としては初出ではなく、2000 年代初頭に Hartmann Neuron というニューラルシンセサイザーが商品化された事があります。商業的にはうまく行きませんでしたが。まだちゃんと資料も読めていませんが、基本的なアプローチとしてはそれと「今の所」近いものがあるかなという感じです。ただ、Google の NSynth はまだこれがほんの入り口ですね。

いわゆる音色モーフィングについて私が思うのは、ここまでの元の音色を幾つか入力してその間で補間をするというのは基本的に両端の決まった線分上の変化なので、まったく存在していなかったものを作り出しているわけではないかな、という事です。Google の資料にも今後の可能性について色々書かれていますが、例えば、オルガンの音がベルの音に変化するのと同じ「変化」をストリングスに適用したらどうなるか? みたいな話は興味を惹かれますね。

今後どういう方向に進んでいくのかわかりませんが、面白いものが出てくるのを期待したいと思います。